Tem alguém aí? Reflexões sobre a interação humano-chatbot

(Especial Núcleo de Referência em Inteligência Artificial Ética e Confiável)

Por Ana Cristina Garcia Bicharra, Luciana Salgado e Fernando Pinto

Reconhecido na história da Ciência da Computação como o pai da Inteligência Artificial (IA), o matemático inglês Alan Turing foi o primeiro a projetar um simulador de conversação humana para ser usado em seu famoso Teste de Turing (Turing, 1950). O objetivo era tentar enganar as pessoas pedindo-lhes que conversassem às cegas, por escrito, com dois interlocutores ao mesmo tempo – um humano e o outro um computador equipado com software que permitia imitar a conversa humana. Se o participante não conseguisse distinguir o humano do software, o computador passou com sucesso no Teste de Turing.

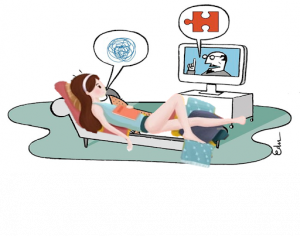

Essa tecnologia conversacional floresceu nos anos 1960 com o desenvolvimento do primeiro chatbot de que se tem notícia, ELIZA (Weizenbaum , 1966) , que era capaz de simular uma conversa com um psicoterapeuta. Durante as trocas, Joseph Weizenbaum, seu criador, observou que algumas pessoas projetavam a ideia de que havia um humano por trás das respostas exibidas na tela, desenvolvendo um afeto ou até mesmo começando a depender emocionalmente dele. A isso Weizenbaum chamou esse fenômeno de “efeito ELIZA”.

O fenômeno descrito em [5] é um exemplo de resposta à dissonância cognitiva causada na interação entre o ser humano e a máquina. Chamamos de dissonância cognitiva a um viés cognitivo que faz com que as pessoas procurem seguir suas crenças e ideologias, embora a realidade dos fatos a desminta. No cenário pós-pandêmico, em que vivemos entremeados pelo negacionismo confirmado por uma enxurrada de fake news, a dissonância cognitiva tem chegado ao seu paroxismo, ameaçando sistemas políticos e a própria civilização. Mas voltando à IA, ao interagir com a ELIZA, os usuários sabem que estão lidando com uma máquina equipada com um software, mas ela responde com a credibilidade que só um humano poderia ter. Isso cria uma dissonância cognitiva ruidosa que pode ser resolvida atribuindo alguma humanidade ao chatbot. Na psicologia, essa atribuição é conhecida como projeção antropomórfica [3].

Essa projeção tem o potencial de criar ilusões na mente humana, como a de lidar com um amigo próximo, a de conversar com esse amigo e a de reciprocidade emocional. Essas ilusões podem criar familiaridade e apego ao chatbot e assim gerar identificação. Dessa forma, o chatbot estaria associado ao que é projetado nele, modificando-se a percepção que se tem dele a ponto de esquecer que é um programa de software.

Portanto, no aspecto da linguagem, o que torna possível a interação com um chatbot baseia-se nas disposições conversacionais que ele oferece. O objeto, no caso o chatbot, parece estar equipado com a capacidade de replicar a interação entre humanos. A simulação conversacional pode, portanto, incitar um modelo de comunicação interativa através do diálogo. Como resultado, enquanto a projeção antropomórfica resolve a tensão criada pela dissonância cognitiva, uma vez iniciado o diálogo com o chatbot, também se torna possível estender os métodos interativos específicos do diálogo entre humanos para não humanos.

O fascínio e a crença de que a inteligência exige a capacidade de interação entre os participantes estimulou o desenvolvimento dos chatbots. Atualmente, ano de 2023, o ChatGPT (Generative Pré-trained Transformer) é o mais moderno dos chatbots e merece nossa atenção. ChatGPT é um robô de conversação desenvolvido pela empresa OpenAI que usa um modelo de geração de linguagem natural baseado em modelos pré-treinados que vão se ajustando usando a técnica de aprendizado não supervisionado, isto é, acha padrões de relações e conceitos nos textos disponíveis na grande base de textos não previamente classificados da Web para gerar respostas às perguntas feitas. Apesar de não gerar perguntas (essencial em um diálogo), a qualidade das respostas geradas pelo ChatGPT é impressionante. Perguntado sobre os impactos psicológicos na interação humano-chatbot, especialmente para indivíduos com depressão, o ChatGPT respondeu (já em português):

“A interação humano-chatbot pode ter impactos psicológicos significativos, especialmente para pessoas com depressão. A depressão é uma doença mental que afeta a forma como as pessoas se sentem, pensam e se comportam, e pode levar a sentimentos de tristeza, perda de interesse, falta de energia e dificuldade em se relacionar com os outros.

Os chatbots podem ser úteis para as pessoas com depressão, pois eles podem fornecer suporte emocional e orientação de forma anônima e acessível. Eles podem ser programados para fornecer respostas compreensivas, encorajadoras e orientadoras, e podem ser acessados 24 horas por dia, 7 dias por semana. Além disso, os chatbots podem ser usados como uma forma de ajudar as pessoas a se expressarem e a processar seus sentimentos.

No entanto, é importante lembrar que os chatbots não são substitutos para o tratamento médico ou psicológico. Eles não podem diagnosticar ou tratar doenças mentais, e as pessoas com depressão devem ser encaminhadas para profissionais de saúde qualificados para o tratamento. Além disso, os chatbots podem ser limitados na sua capacidade de entender e lidar com questões complexas ou nuances emocionais.

Em geral, a interação humano-chatbot pode ser uma ferramenta útil para ajudar as pessoas com depressão a se sentirem menos sozinhas e mais compreendidas. No entanto, é importante lembrar que eles não podem substituir o cuidado médico e psicológico e deve ser usado como complemento ao tratamento.”

Perguntado sobre uma questão mais técnica, porém, mais aberta (“Quais as questões legais, éticas e sociais no uso de chatbots?”), o ChatGPT respondeu:

“Há algumas questões legais, éticas e sociais importantes a serem consideradas no uso de chatbots, incluindo:

- Privacidade: os usuários podem compartilhar informações pessoais com os chatbots, e há preocupações com a segurança dessas informações e como elas são coletadas, armazenadas e utilizadas.

- Transparência: os usuários podem não ser conscientes de que estão falando com um chatbot e não com uma pessoa real, e isso pode levar a mal-entendidos ou a confiança desnecessária.

- Responsabilidade: se um chatbot comete um erro ou causa danos, pode ser difícil determinar a quem atribuir a responsabilidade.

- Impacto no emprego: os chatbots podem ser usados para automatizar tarefas que antes eram feitas por seres humanos, o que pode levar ao desemprego.

- Bias: os chatbots podem replicar os preconceitos e desigualdades presentes no conjunto de dados usado para treiná-los, o que pode levar a respostas imprecisas ou discriminatórias.

Essas questões precisam ser cuidadosamente consideradas e gerenciadas para garantir que os chatbots sejam usados de maneira responsável e ética”

A sofisticação da interação entre chatbots e seres humanos vem sendo explorada em várias áreas de conhecimento e com fins distintos. Na área de marketing, um dos primeiros alvos da confecção de assistentes virtuais, a IA se especializa com o uso de técnicas de customização em massa e de Big Data, assim como sua utilização na formação de personalidade de virtual influencers. Na educação inclusiva, chatbots vem sendo utilizados para assistência ao desenvolvimento de pessoas com algum grau de espectro autista e no campo da Saúde, com o aumento exponencial do uso da telemedicina, os assistentes virtuais têm sido cada vez mais utilizados por cuidadores e profissionais de Saúde, como é o caso do chatbot Wysa, desenvolvido para o cuidado com a saúde mental.

Entretanto, uma área de aplicação que vem se desenvolvendo e tem causado bastante controvérsia é de chatbots capazes de representar pessoas mortas, constituindo-se em algo como um avatar digital pós-morte com o qual um ente querido poderia interagir. Se pensarmos na dificuldade das pessoas lidarem com as perdas de familiares e amigos, utilizar técnicas de IA pode ser uma boa ideia para encaminhar a aceitação do que Sigmund Freud chamou de transitoriedade das coisas e pessoas. Para Freud, numa visão otimista, ter consciência da efemeridade da vida, das coisas e pessoas nos ajuda a elaborar as perdas e ver que a “exigência de imortalidade, por ser tão obviamente um produto dos nossos desejos, não pode reivindicar seu direito à realidade; o que é penoso pode, não obstante, ser verdadeiro.” Já numa visão pessimista, recorrendo a uma alegoria com um poeta, para Freud a finitude das coisas e pessoas acabaria por tirar delas seu valor e beleza: “É impossível que toda essa beleza da Natureza e da Arte, do mundo de nossas sensações e do mundo externo, realmente venha a se desfazer em nada.”, retruca o poeta, negando-se a refrear sua libido frente ao efêmero.

Aqueles que defendem o uso de chatbots de pessoas mortas defendem que esse diálogo post-mortem ajudaria a realizar a finitude e o processo de luto se consubstanciaria nessa interação. Logo, procuram caminhar na direção otimista da noção de transitoriedade freudiana. Entretanto, quanto mais o tipo de chatbot sugere a possibilidade de um relacionamento profundo e pessoal, mais o padrão instintivo de apego emocional parece ser solicitado e, quanto mais a reciprocidade, mais o antropomorfismo intencional do chatbot tem a chance de ser eficaz. Como consequência, além de todos os dilemas éticos envolvidos em utilizar dados de pessoas mortas para simular conversas, o risco de dependência emocional ou alienação deve, portanto, ser considerado, sob a pena de se ter consequências psíquicas e distúrbios relacionados à maneira de se lidar com as perdas e o luto.

Enquanto as áreas de aplicação dos chatbots se multiplicam, a indústria desta tecnologia cresce, com expectativa de atingir US$100 bilhões [4] até 2026. Além dos avanços em IA, como o processamento e compreensão de linguagem e natural, este crescimento é explicado pelo aumento da adesão das pessoas às plataformas conversacionais e foi impulsionado pela difusão de aplicativos disponíveis, como o Siri da Apple e o Bixby da Samsung.

Entretanto, o conhecimento sobre o impacto dos chatbots a nível individual, grupal e social é limitado. [1] investigou até que ponto as expressões usadas pelos chatbots afetam as expressões das pessoas usuárias. Os resultados desta pesquisa indicam que o fluxo da conversa entre chatbots e humanos, impulsionado pelas perguntas feitas pelos chatbots, levam os humanos a um processo de self-disclosure, i.e., de auto-revelação, onde as pessoas passam informações sobre elas próprias para o robô. Entretanto, os chatbots não correspondem e não se auto-revelam, o que pode dificultar a formação de um relacionamento humano-chatbot.

Outras pesquisas na área de Interação Humano-Computador e Experiência do Usuário lidam com desafios novos decorrentes da mudança relativa a transição do design do layout visual e dos mecanismos de interação para o design de uma conversa inclusiva e acessível. Afinal, para que uma conversa entre pessoas e bots seja boa e produtiva, esta conversa precisa atender a propósitos humanos e ser adequada a forma com que humanos se expressam para alcançar suas necessidades.

O debate em torno do uso de uma inteligência artificial responsável [2] para fins terapêuticos ganhou força na última década. Um dos pontos recorrentes são os desafios éticos, de responsabilização e culturais no projeto e no uso de chatbots. Uma vez que tais tecnologias imitam o comportamento humano e são criadas por pessoas com diferentes visões do mundo, os agentes conversacionais podem ser tendenciosos e prejudiciais, assim como as pessoas podem. O futuro desta tecnologia e seus potenciais impactos é, portanto, algo que exige pesquisas interdisciplinares e conectadas à realidade sociopolítica, cultural e de saúde das partes envolvidas.

Referências

[1] Croes, E. A. J.; Antheunis, M. L.; Goudbeek, M. B.; Wildman, N. W. “I Am in Your Computer While We Talk to Each Other” a Content Analysis on the Use of Language-Based Strategies by Humans and a Social Chatbot in Initial Human-Chatbot Interactions, International Journal of Human–Computer Interaction, (2022) , DOI: 10.1080/10447318.2022.2075574

[2] Dignum, V., The role and challenges of education for responsible AI, Lond. Rev. Educ. 19 (2021) 1–11, https://doi.org/10.14324/LRE.19.1.01.

[3] Epley, N., Waytz, A. & Cacioppo, J. T. . When we need a human: motivational determinants of anthropomorphism. Social Cognition, 26, 2, 143-155. (2008) doi: 10.1521/soco.2008.26.2.143

[4] Intelligence, Mordor. “Chatbot Market-Growth, Trends, COVID-19 Impact, and Forecasts (2021-2026).” (2019).

[5] Weizenbaum J, 1966. ELIZA—a computer program for the study of natural language A. Lillywhite, G. Wolbring, Coverage of ethics within the artificial intelligence and machine learning academic literature: the case of disabled people, Assist. Technol. (2019), https://doi.org/10.1080/10400435.2019.1593259.

Sobre os autores

Ana Cristina Bicharra Garcia é professora titular do Departamento de Informática Aplicada da Universidade Federal do Estado do Rio de Janeiro. Ela fundou e coordenou o ADDLabs, um laboratório de pesquisa em IA aplicada. É bolsista de produtividade do Conselho Nacional de Pesquisa (CNPq). Seus interesses de pesquisa incluem IA, big data e computação coletiva para descobrir e monitorar padrões de comportamento humano e de máquina.

Ana Cristina Bicharra Garcia é professora titular do Departamento de Informática Aplicada da Universidade Federal do Estado do Rio de Janeiro. Ela fundou e coordenou o ADDLabs, um laboratório de pesquisa em IA aplicada. É bolsista de produtividade do Conselho Nacional de Pesquisa (CNPq). Seus interesses de pesquisa incluem IA, big data e computação coletiva para descobrir e monitorar padrões de comportamento humano e de máquina.

Fernando Pinto é doutorando em Administração pelo COPPEAD/UFRJ, na área de sistemas de informação, gestão e participação digital, e mestre em Administração. Sua pesquisa gira em torno do uso de tecnologias de informação e comunicação (TIC) por governos e sociedade, bem como o uso de novas tecnologias com impacto social (AI4SG). Durante 15 anos, foi gerente de projetos do laboratório de pesquisa e desenvolvimento em IA e IHC – ADDLabs/UFF.

Fernando Pinto é doutorando em Administração pelo COPPEAD/UFRJ, na área de sistemas de informação, gestão e participação digital, e mestre em Administração. Sua pesquisa gira em torno do uso de tecnologias de informação e comunicação (TIC) por governos e sociedade, bem como o uso de novas tecnologias com impacto social (AI4SG). Durante 15 anos, foi gerente de projetos do laboratório de pesquisa e desenvolvimento em IA e IHC – ADDLabs/UFF.

Como citar esta matéria

Garcia Bicharra, Ana Cristina; Salgado, Luciana; Pinto, Fernando. Tem alguém aí? Reflexões sobre a interação humano-chatbot. SBC Horizontes, SBC Horizontes, Fevereiro 2023. ISSN 2175-9235. Disponível em: <http://horizontes.sbc.org.br/index.php/2023/02/tem-alguem-ai-reflexoes-sobre-a-interacao-humano-chatbot/>. Acesso em:<data>