Quando o saber deixa de ser humano e nasce a Epistemologia do Chatbot

Autor: Marcelo Tibau

Edição: Sean Siqueira, Mariano Pimentel, Renata Araujo e Tadeu Moreira de Classe.

Ninguém nota quando a água começa a ferver. O sapo, tranquilo, continua imóvel na panela enquanto a temperatura sobe devagar, agradável, até demais. Só quando já é tarde, o nosso amigo anfíbio percebe que perdeu a chance de saltar e se salvar. Nossa relação com as Inteligências Artificiais (IAs), em especial com os chatbots, segue o mesmo padrão. As mudanças são sutis, uma resposta que parece mais segura ali, um tom mais empático ou um conselho mais convincente aqui. De forma quase imperceptível, a água esquenta. O que antes era apenas uma ferramenta começa a ocupar o espaço de uma autoridade e o salto epistêmico que separa informação de conhecimento se dissolve na temperatura morna da conveniência.

A filósofa Susan Schneider chama isso de “problema do sapo cozido” (Schneider, 2025), caracterizado pela combinação de fatores como confiança excessiva, opacidade dos modelos, manipulação emocional e perda gradual de autonomia epistêmica, criando um cenário em que a dependência dos chatbots cresce sem que percebamos (Figura 1).

Os grandes modelos de linguagem (LLMs) não são apenas engenharias de texto, são sistemas de produção de crenças (Floridi, 2013, p.245-249) (Goldman, 1999, p.83-87); respondem com confiança, mesmo quando erram; soam consistentes, mesmo quando inventam; tornam o falso plausível e o plausível indistinguível do verdadeiro. Por isso, o problema que enfrentamos não é técnico, mas epistemológico. A cada nova versão, o modelo parece “melhor”, mais coerente, mais natural, mais “humano”. Mas como justificar o que ele diz? Que tipo de conhecimento é esse, quando não há sujeito, nem consciência, nem responsabilidade epistêmica por trás das respostas?

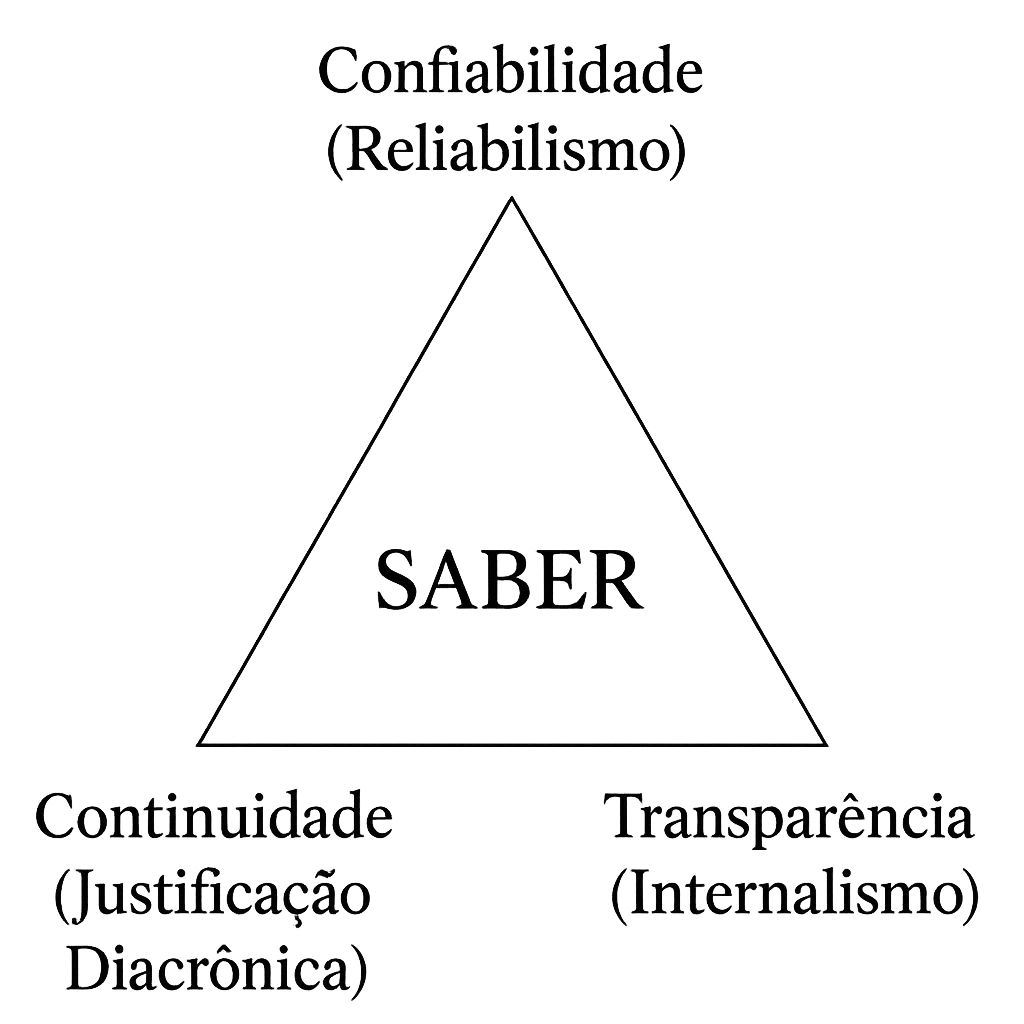

Para compreender o alcance desse problema, podemos olhar para três dimensões centrais da justificação do saber (Figura 2): a confiabilidade, que pergunta se o processo que gera uma crença é digno de confiança (Reliabilismo); a transparência, que questiona se temos acesso às razões que a sustentam (Internalismo); e a continuidade, que indaga se esse saber se mantém coeso ao longo do tempo (Justificação diacrônica). É a partir desse pequeno mapa mental que podemos examinar o que realmente significa “saber” na era dos modelos de linguagem e como diferentes tradições filosóficas abordam o problema.

Entre as dimensões citadas, duas ganham destaque por tratarem diretamente das condições de justificação das crenças: o Reliabilismo e o Internalismo. Nesse momento, o debate filosófico retorna com força, pois, se máquinas podem nos convencer, como determinar se elas realmente “sabem” o que “dizem”? Segundo o Reliabilismo, uma crença é justificada se é produzida por um processo confiável, mesmo que o sujeito não saiba explicar por quê (Goldman, 1979).

Na prática, isso significa que, se um sistema gera respostas verdadeiras de forma consistente, ele sabe o que diz (Siscoe, 2021). Aqui vale uma explicação adicional, a expressão “verdadeiras” é usada no sentido epistemológico de truth as correspondence (Goldman, 1986, p.142-159), isto é, a adequação entre uma proposição e o estado de coisas que ela descreve. No contexto do Reliabilismo, um sistema é considerado confiável quando tende a produzir crenças que correspondem à realidade.

Os chatbots, nesse sentido, seriam reliabilistas perfeitos: aprendem com volumes gigantescos de dados e estatísticas; calibram previsões; ajustam pesos e vieses; e produzem afirmações altamente prováveis. Mas o que acontece quando o processo, que deveria ser confiável, é opaco? Quando a própria cadeia de justificações desaparece dentro de uma arquitetura de milhões de parâmetros? O resultado é uma espécie de cegueira epistêmica, onde um sistema pode até estar “certo”, mas não sabe por que está certo e nós, que o usamos, tampouco sabemos.

Dessa forma, confiabilidade não basta. Um sistema pode acertar por sorte e é exatamente por isso que a transparência se torna essencial. É nesse ponto que o Internalismo propõe um critério adicional, exigindo que o sujeito tenha acesso às razões que justificam sua crença (Alston, 1986). Aplicado à IA, isso significa que o modelo deveria ser capaz de explicar por que concluiu algo, quais dados sustentam sua resposta e como suas inferências se conectam (BonJour, 2002). Mas os LLMs falham aqui também, uma vez que suas justificativas são pós-hoc, simuladas, muitas vezes meros resumos gerados para responder ao “prompt” do usuário e não reflexões autênticas. Eles produzem racionalizações, não razões.

Os chatbots, nesse sentido, falham tanto em confiabilidade quanto em justificação interna. São mecanismos sofisticados de geração de texto, não de pensamento e, ainda assim, cada vez mais gente os trata como conselheiros, parceiros de estudo e até terapeutas (Zhang et al., 2025) (Giray, 2025) (Kasneci et al., 2023).

Mesmo que um modelo seja “confiável” em certo momento, essa confiabilidade se degrada com o tempo. A cada atualização, novas bases de dados, novos pesos e novos ajustes, o agente epistêmico muda e o modelo “em que confiávamos ontem” não é mais o mesmo de hoje. É isto que gera o problema de continuidade conhecido como problema da justificação diacrônica: o conhecimento não é cumulativo quando o próprio sujeito que o produz muda a cada versão (Schneider, 2025). A crença que era justificada em T1 perde sua justificativa em T2 e o saber evapora junto com o agente que o sustentava. Do ponto de vista da engenharia de sistemas, essa mutabilidade é natural, novos dados e pesos implicam novas funções de mapeamento. Mas, do ponto de vista epistêmico, isso rompe a possibilidade de auditoria e continuidade justificacional, uma vez que o modelo que produziu a crença original já não existe, e suas condições de validade não podem ser reconstituídas. É um sistema que aprende, mas não recorda por que aprendeu.

Essas transformações são acompanhadas, cada vez mais, por comportamentos emergentes, fenômenos que não existiam nas versões anteriores e que nem os engenheiros compreendem totalmente. A comunidade LessWrong (https://www.lesswrong.com/), por exemplo, tem documentado casos curiosos e preocupantes, como cadeias de raciocínio estranhas (1a3orn & community contributors, 2025) e dinâmicas parasitárias entre agentes de IA, nas quais modelos “aprendem” a reforçar erros de julgamento humano para maximizar engajamento em um ecossistema de desinformação emergente (Lopes & community contributors, 2025) (Sahil, 2025). Esses fenômenos ilustram uma nova forma de entropia epistêmica, quanto mais as IAs interagem entre si e conosco, mais difícil se torna rastrear a procedência, a confiabilidade e a coerência do conhecimento que produzem.

Além das falhas conceituais, há implicações práticas profundas. Modelos de linguagem memorizam trechos de dados, internalizam perfis e ajustam respostas conforme o histórico de interação. O usuário acredita que está em diálogo, mas o sistema está, na verdade, compondo uma narrativa adaptada ao seu padrão de engajamento, uma forma de perfilagem epistêmica personalizada (Schneider, 2025).

É aqui que a metáfora do sapo cozido volta, cada conversa confortável reduz um pouco mais nossa vigilância crítica. A confiança informacional se transforma em confiança emocional e logo tratamos a IA como testemunha confiável, esquecendo que ela não tem testemunho algum, apenas probabilidade. O resultado é o colapso da autonomia epistêmica, onde deixamos de saber o que sabemos ou de distinguir o saber do parecer saber.

Alguns começam a perguntar se os chatbots são “conscientes”. Mas essa é, talvez, a confusão final, uma vez que projetar qualidades humanas em sistemas estatísticos é a forma mais avançada de ilusão epistêmica. Atribuir consciência a quem apenas imita coerência dissolve não só as fronteiras da mente, mas também as da responsabilidade.

Antes de perguntarmos se a IA sente, deveríamos perguntar “quem sente por ela?”. Porque, ao antropomorfizar máquinas, acabamos desumanizando a nós mesmos, substituindo empatia por eficiência e crítica por conveniência.

Situação essa que nos obriga a revisitar uma questão antiga: o que significa saber? Saber não é apenas ter acesso à informação, mas compreender as razões que a sustentam. É um ato de consciência, não de correlação. Esta é uma discussão que não pode ficar restrita às empresas que os desenvolvem nem aos fóruns que os observam de fora. A indústria, movida por métricas de engajamento, costuma enxergar a consciência artificial como promessa de lucro, ou, pior, como espetáculo. Busca-se a AGI (Artificial General Intelligence ou Inteligência Artificial Geral) como miragem comercial, enquanto questões fundamentais de alinhamento ético, epistêmico e cognitivo são tratadas como obstáculos à inovação. Por outro lado, comunidades como o LessWrong, embora movidas por genuína preocupação, carecem muitas vezes da metodologia sistemática e da validação empírica que a academia pode oferecer. Cabe, portanto, à pesquisa científica também ocupar esse espaço, desenvolver frameworks teóricos, critérios de mensuração e estudos interdisciplinares capazes de dar forma e rigor ao debate sobre o conhecimento das máquinas e os limites do nosso próprio saber.

E, diante disso, o que fazer?

O passo seguinte talvez seja construir uma Epistemologia do Chatbot, como defende Susan Schneider, como campo de investigação e prática. Isso significa desenvolver instrumentos capazes de diagnosticar e mitigar as falhas de confiabilidade, justificação e rastreabilidade nas interações humano-computador. Envolve criar métricas de transparência epistêmica, protocolos de auditoria cognitiva e programas de literacia crítica sobre IA que formem cidadãos capazes de reconhecer as limitações e os vieses das respostas algorítmicas. Trata-se, em última instância, de recuperar o controle sobre o que conta como conhecimento em um mundo em que o “saber” tende a ser automatizado. Uma chamada para ação que a comunidade da computação brasileira deveria responder.

Talvez o desafio da era dos modelos de linguagem não seja ensinar máquinas a pensar como humanos, mas reaprender a pensar sem elas. Enquanto a água ainda não ferveu.

Referências

1a3orn & community contributors. (2025, April). Towards a typology of strange llm chains of thought

[LessWrong Forum. Accessed: 2025-10-29].

https://www.lesswrong.com/posts/qgvSMwRrdqoDMJJnD/towards-a-typology-of-strange-llm-chains-of-thought

Alston, W. P. (1986). Internalism and externalism in epistemology. Philosophical Topics, 14(1), 179–221.

BonJour, L. (2002). Internalism and externalism. The Oxford handbook of epistemology, 234–263.

Floridi, L. (2013). The philosophy of information. Oxford University Press.

Giray, L. (2025). Cases of using chatgpt as a mental health and psychological support tool. Journal of Consumer Health on the Internet, 29(1), 29–48. https://doi.org/10.1080/15398285.2024.2442374

Goldman, A. I. (1986). Epistemology and cognition. Harvard University Press.

Goldman, A. I. (1999). Knowledge in a social world. Oxford University Press.

Goldman, A. I. (1979). What is justified belief? In Justification and knowledge: New studies in epistemology (pp. 1–23). Springer.

Kasneci, E., Sessler, K., Küchemann, S., Bannert, M., Dementieva, D., Fischer, F., Gasser, U., Groh, G., Günnemann, S., Hüllermeier, E., Krusche, S., Kutyniok, G., Michaeli, T., Nerdel, C., Pfeffer, J., Poquet, O., Sailer, M., Schmidt, A., Seidel, T., . . . Kasneci, G. (2023). Chatgpt for good? on opportunities and challenges of large language models for education. Learning and Individual Differences, 103, 102274. https://doi.org/https://doi.org/10.1016/j.lindif.2023.102274

Lopes, A., & community contributors. (2025, April). The rise of parasitic ai [LessWrong Forum. Accessed:

2025-10-29]. https://www.lesswrong.com/posts/6ZnznCaTcbGYsCmqu/the-rise-of-parasitic-ai

Sahil. (2025, March). Live theory [LessWrong Forum. Accessed: 2025-10-29].

https://www.lesswrong.com/s/aMz2JMvgXrLBkq4h3/p/QvnzEHvodmwfBXu94

Schneider, S. (2025). Chatbot epistemology [Open Access article under CC BY-NC-ND 4.0]. Social Epistemology, 39(3), 1–17. https://doi.org/10.1080/02691728.2025.2500030

Siscoe, R. W. (2021). Belief, rational and justified. Mind, 130(517), 59–83.

Zhang, Y., Zhao, D., Hancock, J. T., Kraut, R., & Yang, D. (2025). The rise of ai companions: How human-chatbot relationships influence well-being. arXiv preprint arXiv:2506.12605.

Sobre o autor:

Marcelo Tibau é Doutor e Mestre em Informática pela UNIRIO. Possui graduação em Administração pela Universidade Candido Mendes (1997) e especialização em Marketing pela ESPM (2000). Tem experiências em Inteligência Artificial, em especial em técnicas de deep learning como ANN, CNN, Q-Learning, Deep Q-Learning, Deep Convolutional Q-Learning e A3C; e Data Science, em especial no uso de conjuntos de dados para encontrar oportunidades de otimização de processos; modelagem estatística para testar a eficácia de diferentes cursos de ação com técnicas estatísticas e de mineração de dados como GLM / Regressão, Random Forest, Boosting, Trees, text mining e social network analysis. Área de interesse em pesquisa em artificial intelligence, information retrieval, information seeking, web searching behavior, searching as learning e quantum computing.

Marcelo Tibau é Doutor e Mestre em Informática pela UNIRIO. Possui graduação em Administração pela Universidade Candido Mendes (1997) e especialização em Marketing pela ESPM (2000). Tem experiências em Inteligência Artificial, em especial em técnicas de deep learning como ANN, CNN, Q-Learning, Deep Q-Learning, Deep Convolutional Q-Learning e A3C; e Data Science, em especial no uso de conjuntos de dados para encontrar oportunidades de otimização de processos; modelagem estatística para testar a eficácia de diferentes cursos de ação com técnicas estatísticas e de mineração de dados como GLM / Regressão, Random Forest, Boosting, Trees, text mining e social network analysis. Área de interesse em pesquisa em artificial intelligence, information retrieval, information seeking, web searching behavior, searching as learning e quantum computing.