Vieses de gênero em algoritmos opaque box: Um olhar sobre a regulação jurídica da Inteligência Artificial

por Letícia Lopes Borja

(Especial GEDI)

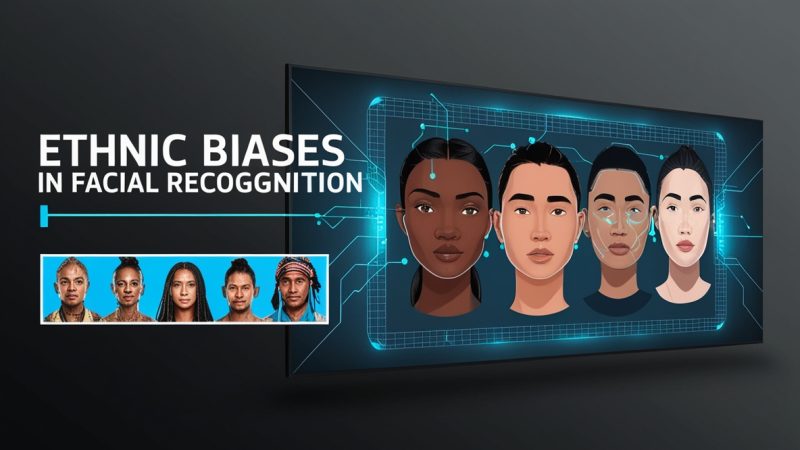

Apesar da tecnologia ser frequentemente entendida como um recurso neutro e naturalmente imparcial, são cada vez mais usuais as situações em que instrumentos tecnológicos produzem discriminações e vulnerabilidades típicas do mundo offline, gerando impactos negativos em destinatários de minorias sociais.

Nesse quadro, vale lembrar que os algoritmos são um produto humano, de modo que sua programação pode estar entrelaçada à visão de mundo dos seus programadores, assim como seu próprio funcionamento pode servir como um repetidor ou amplificador de preconceitos e assimetrias, a exemplo da desigualdade de gênero.

Atualmente, os efeitos dos vieses algorítmicos de gênero já representam um grande desafio para as instituições jurídicas. Todavia, quando se fala em algoritmos opaque box, a tarefa de garantir os direitos fundamentais das usuárias femininas pode se tornar ainda mais complexa, dadas as dificuldades de explicação quanto ao funcionamento desses mecanismos.

Para compreender essa problemática e a conceituação dos algoritmos opaque box, cabe esclarecer que algoritmos que operam pela técnica do aprendizado de máquina são aqueles “programados para aprenderem sozinhos a se programar” (VON ENDE; OLIVEIRA, 2020, p. 212).

O programador indica o objetivo, mas a própria máquina deve encontrar os passos necessários à execução daquela meta, aprendendo por meio da sua própria experiência.

O grande problema dessa ferramenta, no entanto, surge no momento em que os próprios desenvolvedores não conseguem compreender como o algoritmo chegou a determinado resultado. Assim, quando os níveis de complexidade e aprendizagem dos sistemas atingem graus tão profundos ao ponto de eclipsar o processo de tomada de decisão algorítmica (RIBEIRO, 2021), pode-se apontar a existência de um algoritmo opaque box.

Levando em conta os impactos crescentes das decisões automatizadas no estilo de vida contemporâneo – os quais vão desde a seleção de candidatos a vagas de emprego até à formulação de políticas públicas – várias são as preocupações envolvidas no funcionamento desses algoritmos “inexplicáveis”. Entre elas, chama a atenção a possibilidade de enviesamentos de gênero em suas operações, cujo surgimento e desenvolvimento pode ter origem em diversos momentos da programação e funcionamento do algoritmo.

Levando em conta os impactos crescentes das decisões automatizadas no estilo de vida contemporâneo – os quais vão desde a seleção de candidatos a vagas de emprego até à formulação de políticas públicas – várias são as preocupações envolvidas no funcionamento desses algoritmos “inexplicáveis”. Entre elas, chama a atenção a possibilidade de enviesamentos de gênero em suas operações, cujo surgimento e desenvolvimento pode ter origem em diversos momentos da programação e funcionamento do algoritmo.

Apesar do Brasil ainda não possuir nenhum instrumento legal específico para o uso da inteligência artificial, a Lei Geral de Proteção de Dados (LGPD) já garante aos destinatários de decisões automatizadas o chamado “direito à explicação”. Ou seja, o titular dos dados tem o direito de conhecer a lógica subjacente ao funcionamento dos algoritmos, inclusive com a possibilidade de solicitar uma auditoria para a verificação de aspectos discriminatórios no tratamento de dados pessoais.

Portanto, frente à uma decisão automatizada potencialmente enviesada – a exemplo da ferramenta de recrutamento da Amazon que dava preferência a candidatos do sexo masculino – o indivíduo prejudicado poderá questionar o controlador, o qual deverá fornecer, sempre que solicitado, informações claras e adequadas a respeito dos critérios e dos procedimentos utilizados para a decisão automatizada, observados os segredos comercial e industrial.

Como garantir tal direito à explicação nos casos em que os vieses de gênero se encontram em algoritmos opaque box?

Dada a complexidade tecnológica desses sistemas opacos, muitas empresas de tecnologia vêm se utilizando do argumento da “impossibilidade técnica” para justificar o não fornecimento de determinadas informações relevantes à compreensão do funcionamento do algoritmo e da presença de possível discriminação de gênero.

Tal alegação parte da perspectiva de que, como o comportamento do modelo não está ao alcance do próprio programador, não seria possível a cooperação dos desenvolvedores com as autoridades estatais no sentido de eliminar um acusado viés de gênero nas máquinas. Com isso, as entidades também se desobrigam quanto aos custos de atender e responder pedidos de interceptação e quebras de sigilo em relação ao desenho algorítmico (ABREU, 2017).

Apesar da frequência com que essa justificativa vem sendo vislumbrada, surgem incertezas quanto à veracidade e legalidade desse argumento, de modo que sua aderência é cada vez menor entre legisladores e juízes.

Não se trata, porém, de negar a impossibilidade técnica, mas sim de se compreender que os agentes devem controlar as ferramentas que desenvolvem, responsabilizando-se por resultados discriminatórios a grupos minoritários, principalmente às mulheres (LINDOSO, 2019).

Ante a exigência legal de transparência e o compromisso ético dos programadores com a igualdade de gênero, soluções como o desenvolvimento de IAs explicáveis podem representar alternativas viáveis de mitigação da problemática discutida, tanto no sentido de garantir o direito à explicação quanto de combater a discriminação algorítmica.

Referências

ABREU, Jacqueline de Souza. Passado, presente e futuro da criptografia forte: desenvolvimento tecnológico e regulação. Revista Brasileira de Políticas Públicas, Brasília, v. 7, n. 3, p. 24-42, 2017.

LINDOSO, Maria Christine Branco. Discriminação de gênero em processos decisórios automatizados. 2019. 116f. Dissertação (Mestrado em Direito) – Universidade de Brasília, Brasília, 2019.

RIBEIRO, Ana Lídia Lira. Discriminação em algoritmos de inteligência artificial: uma análise acerca da LGPD como instrumento normativo mitigador de vieses discriminatórios. 2021. 61 f. Trabalho de Conclusão de Curso (Bacharelado em Direito) – Universidade Federal do Ceará, Fortaleza, 2021.VON ENDE, Luiza Berger; OLIVEIRA, Rafael Santos de. Desigualdade de gênero e tecnologia: entre mulheres e algoritmos. Revista Brasileira de Iniciação Científica, [S.l.], v. 7, p. 210-219, 2020.

Sobre a autora

LETÍCIA LOPES BORJA é graduanda em Direito pela Universidade Federal do Rio Grande do Norte (UFRN). Membro-pesquisador do Grupo de Estudos de Direito Público da Internet e das Inovações Tecnológicas (GEDI). Bolsista de Iniciação Científica no Observatório de Direito Internacional do Rio Grande do Norte (OBDI). Membro do Conselho Editorial da Revista Jurídica In Verbis (UFRN) e da Revista Estudantil Manus Iuris (UFERSA). Currículo Lattes: http://lattes.cnpq.br/6127647534294314.

LETÍCIA LOPES BORJA é graduanda em Direito pela Universidade Federal do Rio Grande do Norte (UFRN). Membro-pesquisador do Grupo de Estudos de Direito Público da Internet e das Inovações Tecnológicas (GEDI). Bolsista de Iniciação Científica no Observatório de Direito Internacional do Rio Grande do Norte (OBDI). Membro do Conselho Editorial da Revista Jurídica In Verbis (UFRN) e da Revista Estudantil Manus Iuris (UFERSA). Currículo Lattes: http://lattes.cnpq.br/6127647534294314.

Como citar esta matéria

BORJA, Letícia. Vieses de gênero em algoritmos opaque box: Um olhar sobre a regulação jurídica da Inteligência Artificial SBC Horizontes, SBC Horizontes, Junho 2021. ISSN 2175-9235. Disponível em: <https://horizontes.sbc.org.br/index.php/2022/01/vieses-de-genero-em-algoritmos-opaque-box-um-olhar-sobre-a-regulacao-juridica-da-inteligencia-artificial/>. Acesso em:<data>