O papel da computação na guerra contra “fake news”

Por Lara Piccolo (The Open University)

Ninguém está imune às ‘Fake News‘. Independente das mídias sociais que você usa, opinião política, idade ou formação acadêmica, tenho certeza que você não precisa procurar muito para encontrar no seu smartphone uma postagem que gerou alguma dúvida, indignação, e de repente até aquela vontade de encaminhar o conteúdo para alguém – mesmo desconfiando.

As chamadas ‘Fake News’ podem ser tanto uma peça de desinformação – informação fabricada com a intenção de influenciar opiniões, geralmente de forma atrativa e explorando nossas tendências e parcialidades; ou misinformação, que também é falsa, mas sem a intenção direta de causar danos [1]. Aquelas dicas de saúde milagrosas longe de serem comprovadas são exemplos de misinformação.

Embora o real impacto dessa desordem informacional [2] provocada pelo compartilhamento de postagens falsas seja difícil de ser mensurado, sabe-se que esse problema tem afetado diversos sistemas democráticos pelo mundo [3], e no Brasil não tem sido diferente [4]. O estudo em fact-checking reportado em [5] estima que a cada 10 mensagem compartilhadas em grupos no WhatsApp durante as últimas eleições, 4 eram comprovadamente falsas!

Se o problema todo é mediado por sistemas computacionais (as plataformas de mídias sociais, a fabricação de imagens e vídeos, os robôs que promovem desinformação, etc.), é natural imaginar que a solução também está na esfera computacional, mas não é bem assim. Valores pessoais, crenças, motivações individuais, letramento midiático e informacional [6] e aspectos legais da regulamentação das plataformas e ferramentas são exemplos dos fatores envolvidos que tornam esse problema ainda mais complexo [1].

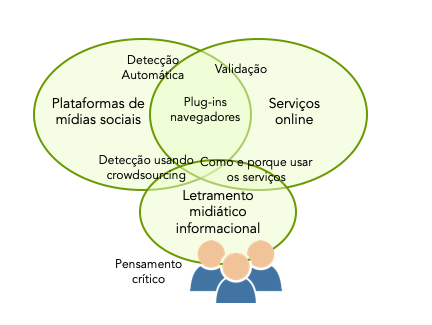

Ferramentas que ajudam usuários de mídias sociais a detectar informações falsas ou a validar a credibilidade de conteúdos e perfis existem e estão disponíveis como plug-ins de navegadores ou serviços online (alguns poucos exemplos: Botometer, Foller.Me, TinEye, Rbutr), e novas soluções estão sempre surgindo. A grande maioria é baseada em Inteligência Artificial (IA) e buscam por padrões linguísticos no texto, na forma de compartilhamento, ou por sinais de alteração em imagens e vídeos. Algumas também contam com informações agregadas via crowdsourcing.

Junto com os alunos do curso de Letramentos Digitais e a Desordem Informacional da UNESP, em Maio de 2019, fizemos um exercício rápido para experimentar várias dessas ferramentas e o resultado não foi bom. Algumas ferramentas foram consideradas muito complexas para usuários não especialistas interagirem e não são amigáveis para uso em smartphones, outras mostraram vários resultados falsos e, no contexto brasileiro, falharam por não mapearem nenhuma informação referente a tópicos bastante falados por aqui, provavelmente por uma restrição para lidar com a Língua Portuguesa. Em resumo, essa atividade demonstrou que as ferramentas todas têm limitações e que se o usuário não entender como elas funcionam e porque elas falham, a frustração é inevitável.

A verdade é que ainda não há solução computacional que substitua o pensamento crítico humano. Na guerra contra a desordem informacional, os fact-checkers estão na linha de frente fazendo apurações jornalísticas, buscando evidências e comprovando a veracidade (ou não) do que tem sido publicado. Algumas ferramentas, como a que estamos desenvolvendo no contexto do projeto europeu Co-Inform [7], buscam facilitar o acesso à informação verificada por fact-checkers nas redes sociais. Mas lidar com a velocidade e o volume de informação circulando nas plataformas de redes sociais vai além da capacidade de qualquer exército de fact-checkers. Nesse caso, IA é uma aliada fundamental, mas a tecnologia ainda não é robusta a ponto de ter a última palavra ao julgar fatos e afirmações. O Parlamento Europeu reconhece essa limitação e defende a regulamentação para que a IA seja moderada pela inteligência humana para evitar que o julgamento artificial seja uma ameaça à liberdade de expressão, pluralismo de ideias e à democracia [8][9].

Se distinguir fato de ficção tem sido extremamente complexo para humanos, treinar e entender os sistemas computacionais pra esse fim também requerem pensamento crítico. Por isso, modelos baseados em transparência, que informam o usuário a respeito das premissas e processos de decisões são fundamentais nesse contexto [8].

Por um lado, pensamento crítico não deve ser restrito à fact-checkers. Cabe a cada um de nós refletir se e como a informação que compartilhamos contribui de alguma forma para a sociedade. Por outro lado, as ferramentas computacionais devem ser baseadas na transparência e no letramento informacional gradual, considerando que o cidadão comum, inclusive aqueles membros do grupo da família no WhatsApp que sempre compartilham de tudo, podem e devem ser considerados potenciais usuários.

Se almejamos uma sociedade mais crítica e democrática, todos temos que ser soldados nessa guerra.

Ilustrando e ideia desse artigo, a figura acima sumariza a natureza dos sistemas computacionais e o papel do pensamento crítico e letramento midiático e informacional.

[1] Lara S. G. Piccolo, Somya Joshi, Evangelos Karapanos, Tracie Farrell (2019) Challenging Misinformation: Exploring Limits and Approaches. Human-Computer Interaction – INTERACT 2019. Lecture Notes in Computer Science, vol 11749. Springer, Cham

[2] Claire Wardle, Hossein Derakhshan (2017) Information disorder: Toward an interdisciplinary framework for research and policymaking. Tech. rep., Council of Europe.

[3] Dominic DiFranzo, Kristine Gloria-Garcia (2017) Filter bubbles and fake news. XRDS 23(3), 32–35 (Apr 2017).

[4] Josemar Alves Caetano, Gabriel Magno, Marcos Gonçalves, Jussara Almeida, Humberto T. Marques-Neto, Virgílio Almeida (2019) Characterizing Attention Cascades in WhatsApp Groups 10th ACM Conference on Web Science (WebSci ’19). ACM, NY, 27–36.

[5] Cristina Tardáguila. Falsehoods outperform facts in Brazilian WhatsApp groups, study shows. Poynter. October 4, 2019.

[6] Christiana Varda e Eleni A. Kyza. Media and Information Literacy: Why does it matter? Co-inform Blog – December 2019.

[7] Martino Mensio, Lara Piccolo, Tracie Farrell. Combating misinformation: the importance of human judgement. Co-inform Blog – May 2019.

[8] Chris Marsden, Trisha Meyer (2019) Regulating disinformation with artificial intelligence: effects of disinformation initiatives on freedom of expression and media pluralism.

[7] Martino Mensio, Harith Alani (2019). MisinfoMe: Who’s Interacting with Misinformation? 18th International Semantic Web Conference (ISWC 2019): Posters & Demonstrations, Industry and Outrageous Ideas Tracks, 26-30 Oct 2019, Auckland, New Zeeland, CEUR WS.