Música e tecnologia

Neste artigo, o autor apresenta parte da linha do tempo das relações entre música e tecnologia, destacando as formas como as mídias eletrônicas e computacionais podem estar presentes na prática musical hoje, seja na criação, performance ou análise. Boa leitura!

Por Danilo Rossetti

A música é uma arte em que a tecnologia, ao longo da história, normalmente caminhou junto com as suas realizações. Ainda que em condições artesanais em alguns casos, a confecção de um instrumento musical envolve conhecimentos técnicos específicos. Os equipamentos eletrônicos passaram a fazer parte da prática a partir do final do século XIX, com a invenção de aparelhos que possibilitavam a gravação sonora, primeiro em cilindro de cera e logo após, no século XX, suportes como discos de vinil e fitas magnéticas. Juntamente a este acontecimento, a criação de instrumentos eletrônicos começou a acontecer por volta do mesmo período. Com os sistemas de distribuição de eletricidade e comunicação, uma quantidade deles começou a surgir, tais como o telégrafo musical, telarmônio, órgão eletrônico, theremin e ondes-martenot.

A incorporação de forma sistemática de equipamentos de gravação e reprodução, assim como dos primeiros sintetizadores analógicos na atividade de criação musical, ocorreu a partir dos anos 1940. Temos, nesse período, a realização dos primeiros experimentos musicais relacionados à música concreta, por Pierre Schaeffer e Pierre Henry, por meio de manipulações de gravações sonoras, primeiramente no Studio d’Essai e depois no Groupe de Recherches Musicales, na França. Há também, logo depois, no Estúdio da Rádio de Colônia (WDR), o desenvolvimento da música eletrônica através de composições realizadas por meio do método serial, utilizando como material sintetizadores analógicos, geradores de ruídos e impulsos como material, e utilizando técnicas como a síntese aditiva ou subtrativa desses sons.

Vídeo 1: Pierre Schaeffer & Pierre Henry: Orphée 53

Vídeo 2: WDR Electronic Music Studio

Nos anos 1950, computadores começaram a ser utilizados como suporte ao fazer musical. É importante salientar que essa incorporação aconteceu de diferentes maneiras ao longo do tempo, ou seja, o computador, por ser uma ferramenta maleável e adaptativa, pode desempenhar diferentes funções dentro da prática musical, seja na criação, performance ou análise musical (ROADS, 1996). A seguir, comentamos algumas dessas possibilidades:

Música algorítmica e síntese sonora

As primeiras melodias em ambiente digital foram geradas pelo computador CSIR 1, em 1950, na Austrália. Alguns anos depois, em 1957, ocorreu o experimento da Suite Illiac, para quarteto de cordas, a primeira obra musical composta por um computador, realizada na Universidade de Illinois Urbana-Champaign, por Lejaren Hiller e Leonard Issacson. A programação foi realizada no computador ILLIAC, por meio de manipulações de ritmos, dinâmicas, contraponto, além de sintaxes generativas e cadeias de Markov.

Vídeo 3: Lejaren Hiller – Illiac Suite for String Quartet

Figura 1: Cartão de memória do ILLIAC I.

Fonte: Wikipédia.

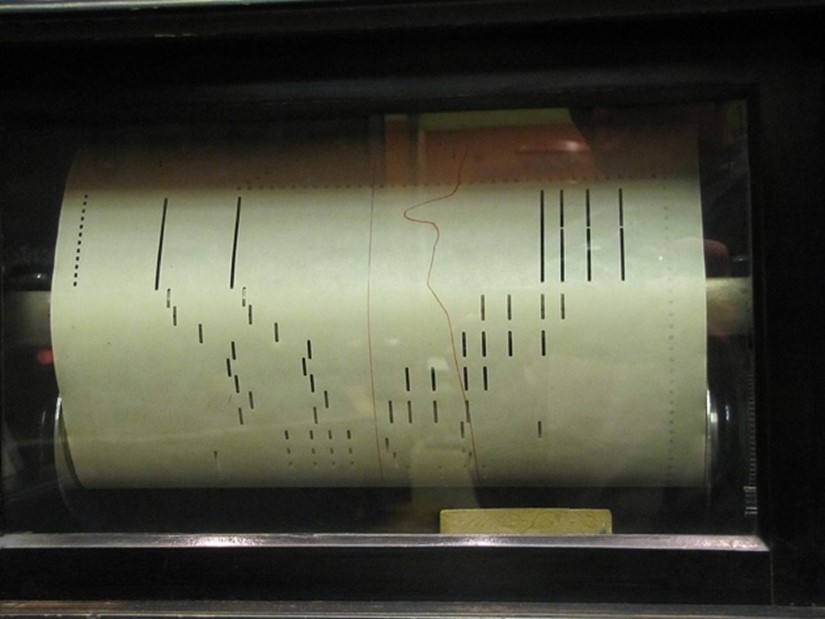

O primeiro sintetizador eletrônico, o RCA Mark II, foi instalado em 1957 no Centro de Música Eletrônica Columbia-Princeton. Este instrumento digital foi utilizado por uma série de compositores que passaram por esse estúdio para compor as suas peças, tais como Otto Luening, Milton Babbitt e Vladmir Ussachevsky. O RCA Mark II possuía um sequenciador binário automatizado que utilizava uma fita perfurada similar à de uma pianola para enviar informações ao sintetizador e ao mecanismo de reprodução sonora do computador. Uma das peças compostas exclusivamente com sons gerados por este sintetizador é Composition for Synthesizer (1961), de Babbitt.

Vídeo 4: Composition for Synthesizer

Figura 2: Fita perfurada de uma pianola.

Fonte: Wikipédia.

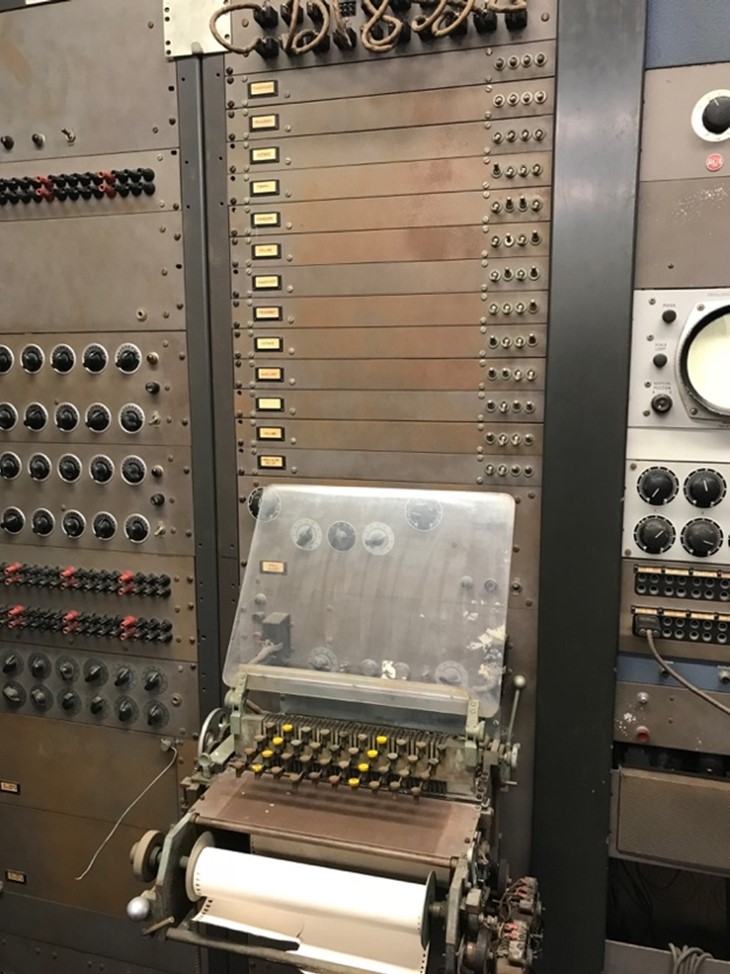

Figura 3: RCA Mark II.

Fonte: Arquivo pessoal do autor.

Outro centro importante de pesquisa que contava com a utilização de computadores na música foram os Laboratórios Bell (Bell Telephone Laboratories). Nesse laboratório, Max Mathews desenvolveu a série de programas Music N (Music I a V), que realizavam diferentes formas de síntese sonora digital. O Music, por sua forma de programação, pode ser considerado o antecessor direto de programas mais recentes como o CSound e, indiretamente, de outros como Max/MSP e Pure Data. Nesse mesmo laboratório, Jean-Claude Risset desenvolveu sua pesquisa sobre a síntese digital de sons instrumentais, estudando como reproduzir digitalmente o espectro sonoro de uma série de instrumentos acústicos (Risset, 1969). Laurie Spiegel também realizou importantes contribuições nesse local, realizando pesquisa artística em música eletrônica e computação gráfica, utilizando lógica algorítmica em seu processo criativo. Aqui podemos assistir a ela realizando uma performance no sintetizador Hal Alles, em 1977.

Vídeo 5: Laurie Spiegel Playing 1977 Bell Labs Hal Alles Synth

O Csound foi desenvolvido em 1985 no MIT, baseado no seu antecessor, o Music 11, e utiliza dois tipos de arquivos de texto na entrada: orchestra,que descreve as características dos instrumentos a serem criados, e score, que descreve as alturas e outros parâmetros musicais. Através do processamento dessas informações, o Csound renderiza um arquivo de áudio em sua saída. Com um funcionamento similar há também o programa SuperCollider, uma linguagem de programação desenvolvida a partir de 1996, utilizada para síntese de áudio em tempo real e composição algorítmica. O seu ambiente também é baseado em dois componentes, um servidor e um cliente, que se comunicam via OSC (Open Sound Control).

Interfaces gráficas

A compositora Daphne Oram, além de seu extenso trabalho na criação de obras eletrônicas, desenvolveu no final dos anos 1950 um equipamento chamado oramics, que permitia a realização gráfica do desenho sonoro diretamente numa película fílmica de 35mm. Por meio das formas desenhadas nas películas, era possível controlar parâmetros sonoros como altura, timbre e amplitude dos sons gerados. O oramics consistia em uma mesa retangular de metal na qual eram esticadas dez películas de filme sincronizadas em que os músicos podiam realizar seus desenhos de maneira a simular uma escrita textural a diferentes vozes. Para a geração do som, essas películas eram lidas por células fotoelétricas e transformadas em som. Esse procedimento é de certa maneira análogo à técnica de desenho sonoro empregada pelos cineastas e animadores Norman McLaren e Evelyn Lambart, que também realizaram algumas composições sonoras de seus filmes desenhando figuras e padrões como pontos, triângulos e círculos na área da banda sonora da película.

Figura 4: Oramics em exposição no Museu da Ciência, em Londres, em 2011.

Fonte: Wikipedia.

Um outro exemplo dessa relação entre desenhos gráficos e música mediada por computador se encontra no desenvolvimento da ferramenta UPIC (Unité Polyagogique Informatique CEMAMu) pelo compositor e arquiteto Iannis Xenakis, no Centre d’Études de Mathématique et Automatique Musicales (CEMAMu), em Paris (1977). Fisicamente, o UPIC possuía uma interface tal como uma mesa digitalizadora ligada a um computador. Nessa mesa, o/a compositor/a desenhava ondas sonoras em um espaço retangular formado pelos eixos X (tempo) e Y (frequência), que também poderiam submetidas a transformações algorítmicas como transposições para outras frequências, reversões, inversões etc. Além de Xenakis, o UPIC foi utilizado como ferramenta composicional por diversos compositores e seus arquivos e documentos são mantidos atualmente pelo Centre Iannis Xenakis. Uma das composições realizadas por Xenakis nesse sistema é Mycenae Alpha (1978), para o Polytope de Micenas. Seu áudio e realização gráfica podem ser acessados no vídeo a seguir:

Vídeo 6: Mycenae Alpha

Atualmente existe o programa Iannix, que simula os processos composicionais do UPIC, além de um recente livro que sintetiza historicamente a pesquisa musical realizada com auxílio do UPIC, além de outras formas de criação musical com auxílio de ferramentas gráficas (WEIBEL; BRÜMMER; KANACH, 2020).

Música Mista

A música mista é aquela que congrega instrumentos acústicos e sons eletroacústicos. A integração entre esses dois universos pode se dar de diferentes maneiras. Em uma delas, os sons eletroacústicos podem ser compostos previamente no momento de criação da peça e gravados em um suporte fixo (disco, fita magnética, CD, HD etc.). Nesse caso, no momento da performance, o/a instrumentista deve tocar junto com essa gravação. Outra possibilidade é haver a transformação ao vivo dos sons instrumentais ou vocais por instrumentos eletrônicos analógicos ou digitais. Esses sons são captados por microfones, enviados para o dispositivo que faz o processamento sonoro e, em seguida, enviados para serem difundidos pelos alto-falantes. Esse é o caso da música mista em tempo real. Uma terceira opção é a combinação dessas duas possibilidades: sons eletroacústicos armazenados em suporte fixo e o processamento em tempo real de sons instrumentais e/ou vocais podem ocorrer simultaneamente. Uma quarta possibilidade a ser considerada é o caso das obras multimodais interativas que apresentam sistemas computacionais que congregam diferentes tipos de expressões artísticas, como música instrumental e eletroacústica, canto/fala, recursos audiovisuais, dança, iluminação etc., com outros tipos de equipamentos tais como sensores de movimento e dispositivos de realidade virtual.

O início da música mista, ainda nos anos 1950, foi marcado pelo uso da parte eletrônica em suporte fixo. Já nos anos 1960 apareceram as primeiras obras mistas com eletrônica ao vivo, com processamento realizado por equipamentos analógicos como moduladores em anel. No início dos anos 1980 temos realizações dos processamentos eletrônicos ao vivo por computadores. A estação de trabalho musical 4X permitia ao músico a manipulação digital do som por meio de processamentos de análise e síntese sonora, além de transformações em tempo real dos sons captados de instrumentos acústicos. A primeira obra a utilizar a 4X foi Répons, de Pierre Boulez, em 1981, para orquestra de câmara, seis instrumentos solistas e eletrônica ao vivo, realizada no IRCAM de Paris (Institut de Recherche et Cordination Acoustique/Musique).

Figura 5: Sala de computadores principal do IRCAM. No centro da imagem estão os racks com os processadores de áudio (1989).

Fonte: Wikipédia.

A aventura computacional do desenvolvimento de ferramentas para música também teve outros desenvolvimentos no IRCAM como o programa Max, que teve seu aniversário de 30 anos em 2019. Esse programa, uma referência dentro da música com auxílio de computadores, é um ambiente de programação que propicia aplicações audiovisuais interativas em tempo real. A pesquisa sobre o Max começou em 1985, com a vinda de Miller Puckette para trabalhar no IRCAM no desenvolvimento de uma interface gráfica para música interativa. No primeiro momento o Max apenas enviava mensagens de controle para equipamentos externos como sintetizadores e samples, via protocolo MIDI. O processamento de áudio em tempo real foi incorporado em 1989 usando um DSP (Digital Signal Processor) interno, passando então a se chamar Max/MSP.

Com a sua saída do IRCAM em 1990, Puckette desenvolveu um ambiente visual de programação similar ao Max em código aberto, o Pure Data– Pd, programa também largamente utilizado para a criação e performance da música mista. Por ser um programa em código aberto, propicia uma vantagem em relação ao Max em termos pedagógicos, facilitando a sua utilização em aulas e cursos voltados à criação musical com suporte computacional. Puckette ainda desenvolveu um livro que é um catálogo de processamentos de áudio voltados à música mista bastante útil para desenvolvimento de patches em Pd (PUCKETTE, 2006).

A ideia de interação entre sons eletroacústicos e acústicos sempre fez parte da discussão da música mista. No entanto, essa ideia nunca esteve tão potencializada como nos dias atuais, devido à variedade de ferramentas tecnológicas existentes aplicadas a composições multimodais. A partir da utilização de novas tecnologias e interfaces, os intérpretes instrumentais ganharam mais autonomia e possibilidades, podendo controlar nuances tímbricas da resposta do processamento sonoro ao vivo, além de uma interação sonora e visual mais elaborada por meio de sensores de movimento, interferências no resultado visual e outras possibilidades. Assim, o intérprete pode ser colocado no centro nesse sistema interativo, por meio da expansão do seu instrumento para esse universo.

MIR

A pesquisa relacionada à computação musical também seguiu um outro caminho através da área conhecida como Music information retrieval (MIR) ou Recuperação da informação musical. É um campo de pesquisa interdisciplinar que se baseia em diferentes áreas como musicologia, psicoacústica, psicologia, processamento de sinais, informática, machine learning. Basicamente, as ferramentas utilizadas, conhecidas como descritores, extraem informações de gravações de áudio com o intuito de revelar dados específicos sobre elas. Algumas das aplicações relacionadas à MIR são a classificação de gêneros musicais, reconhecimento de instrumentos, transcrição musical automática, música generativa, ou ainda aplicações musicológicas para análise musical.

Os próprios programas Max/MSP e Pure Data possuem objetos e bibliotecas externas voltadas para a MIR (Ircamdescriptors, Pdescriptors, ZSAdescriptors), assim com existem programas como o Sonic Visualiser, desenhados exclusivamente para o estudo de gravações de áudio, voltado para musicólogos e pesquisadores em processamento de sinal. Existem ainda bibliotecas desenvolvidas em outras linguagens como a Librosa, em Pyton, para análise musical e de arquivos de áudio em geral, e ainda a biblioteca MIRtoolbox, em MATLAB.

Panorama atual no Brasil

Desde a composição da primeira peça de música eletroacústica por um compositor brasileiro, SiBemol, de Reginaldo de Carvalho, em 1956, até os dias atuais, muita coisa ocorreu. Houve o desenvolvimento de muitos centros de pesquisa em computação musical, música eletroacústica e sonologia, principalmente dentro de universidades. Esses centros, tal como apresentado pela diversidade de abordagens e possibilidades de aplicação de recursos tecnológicos na prática e teoria musical, se concentram em diferentes áreas de estudo, cada qual voltado às suas especificidades.

Além disso, muitos eventos e festivais sobre o tema ocorreram e continuam a ocorrer. O Simpósio Brasileiro de Computação Musical (SBCM), que chega à sua 18ª edição em 2021, mantém uma tradição de 27 anos como um evento que congrega pesquisadores e artistas nacionais e internacionais da área. Houve ainda eventos menos duradouros mas com importância que reverbera até hoje no meio, como o Encontro Internacional de Música e Arte Sonora (EIMAS), na UFJF.

Há também bienais que mostram a produção musical nacional e internacional no campo da música eletroacústica, como a Bienal Internacional de Música Eletroacústica de São Paulo, que teve a sua XIII edição em 2020, assim como a Bienal de Música Contemporânea da Funarte (XXIII edição em 2019), que reserva há muitos anos uma categoria para produções de música eletroacústica acusmáticas e mistas.

Referências

PUCKETTE, Miller. The Theory and Technique of Electronic Music. World Scientific Publishing, 2006. Disponível em http://msp.ucsd.edu/techniques.htm. Acesso em 04 mai. 2021.

RISSET, Jean-Claude. An Introductory Catalogue of Computer Synthesized Sounds. Murray-Hill: Bell Telephone Laboratories, 1969.

ROADS, Curtis. Computer Music Tutorial. Cambridge: MIT Press, 1996.

WEIBEL, Peter; BRÜMMER, Ludger; KANACH, Sharon. From Xenakis’s UPIC to Graphic Notation Today. Berlin: Hatje Cantz, 2020.

Sobre o autor

Danilo Rossetti é professor, pesquisador e compositor cujo trabalho se concentra na pesquisa interdisciplinar por meio do uso de tecnologias, metodologias e práticas colaborativas em processos criativos, performances e análises musicais. É professor do Departamento de Artes da UFMT e professor colaborador da Pós-Graduação em Música do Instituto de Artes da UNICAMP. Realizou pesquisa de pós-doutorado no Núcleo Interdisciplinar de Comunicação Sonora da UNICAMP, e é doutor em Música pela mesma instituição, com período sanduíche no Centre de Recherche Informatique et Création Musicale da Université Paris 8. Suas composições para diferentes formações instrumentais (solos ou conjuntos de câmara), eletroacústicas (acusmáticas e mistas) e multimodais (instalações audiovisuais, música e dança, criações virtuais e música telemática) foram apresentadas em diversos eventos como ICMC, CMMR, NYCEMF, CICTem, NIME, NowNet Arts, BIMESP, SBCM, ANPPOM, File Hipersônica e Bienal de Música Contemporânea da FUNARTE.

Como citar este artigo

ROSSETTI, Danilo. Música e tecnologia. SBC Horizontes, mai. 2021. ISSN 2175-9235. Disponível em: <http://horizontes.sbc.org.br/index.php/2021/05/musica-e-tecnologia/>. Acesso em: DD mês. AAAA.