“IA preconceituosa” pode estar por trás do acidente aéreo que matou 113 pessoas

por Jade Scobri | Curitiba, Brasil

A SBC Horizontes recebeu com exclusividade informações de que a equipe que atuou na parte da Inteligência Artificial (IA) do iWear comunicou à diretoria da empresa sobre irregularidades nos dados utilizados para treinamento do sistema.

De acordo com a nossa fonte, que obteve acesso à comunicação, a equipe de IA solicitou uma nova base de dados para treinamento do sistema por considerar que os dados disponíveis não eram suficientes para treinar o modelo para identificar corretamente situações de estresse dos usuários.

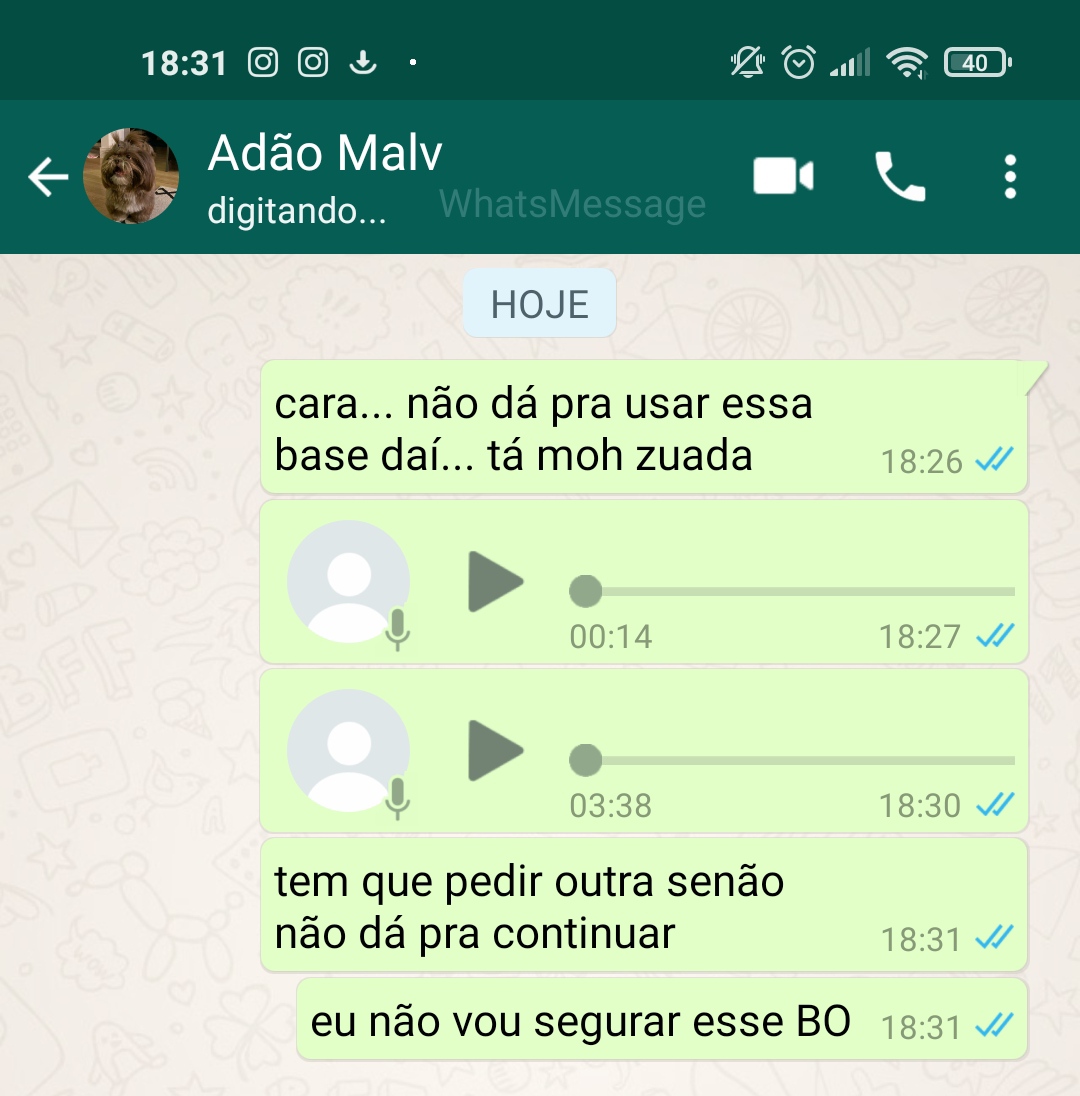

Imagens fornecidas pela fonte em exclusividade para a SBC Horizontes.

Segundo sondagens da nossa fonte, a real preocupação da equipe era com a representatividade dos dados e com a qualidade da rotulagem. “Os dados disponíveis para treinamento e teste foram considerados muito homogêneos pela equipe, obtidos de pessoas com perfis muito próximos. Então a equipe tinha dúvidas se o sistema teria um bom desempenho em um contexto real onde a diversidade de perfis dos usuários é muito maior e impossível de ser antecipada”.

A fonte explicou que a Vina Systems adquiriu a base de dados pronta, com os dados rotulados. “Mais tarde, um dos membros da equipe descobriu que a base tinha sido criada em um projeto de pesquisa de uma faculdade estrangeira, que tinha como objetivo medir os níveis de estresse, ansiedade e qualidade de vida em homens que praticavam meditação com regularidade na terceira idade. O perfil dos participantes era bastante homogêneo: homens, com mais de 65 anos, aposentados, praticantes regulares de golfe ou poker. A maior parte desses homens se autodenominava branco e com renda familiar acima da média.”

Além da baixa variedade dos dados, a fonte destacou questionamentos da equipe sobre a qualidade da rotulagem: “O processo de rotulagem da base foi terceirizado e o projeto pagou um valor fixo para obter os dados rotulados. Eles não conseguiram informar quem fez e como fez o processo de rotulagem. Nós suspeitamos que é um caso de labeling farm predatória!“

Labeling farms é um termo usado para serviços de rotulagem de dados feita por humanos para uma coleção de dados usada para treinar um modelo de machine learning. Em uma investigação recente, o The Intercepted revelou esquemas de exploração em que pessoas eram submetidas a jornadas exaustivas para rotular dados complexos, que causavam danos à percepção ou envolviam conteúdo perturbador, como cenas de violência e abusos. Foram identificados casos de pessoas trabalhando mais de 20 horas diárias nesse tipo de rotulagem para alcançar metas e receber menos de 5 dólares. A penalização pelo tempo ocioso levava a situações extremas em que as pessoas não saiam da frente de seus computadores nem para ir ao banheiro.

Consultado pela reportagem, o Professor Fabiano Silva, da UFPR, comentou a questão: “Nas aplicações de IA, a Aprendizagem de Máquina tem como propósito aprender a partir de dados. Esse aprendizado pode ocorrer de diversas formas. Aqui, estamos falando de aprendizagem supervisionada, que treina um modelo com dados conhecidos, tanto de entrada quanto de saída e, desta forma, consegue prever resultados a partir de novos dados de entrada.”

No caso da Vina Systems, nossa fonte explicou que a rotulagem define se os dados de determinada pessoa indicam uma situação de estresse com risco baixo, normal, alto ou extremo. Fabiano explicou que essa rotulagem é uma das atividades mais importantes, pois ela determina a qualidade do modelo que será utilizado para tomar decisões futuras. “A precisão de um modelo de aprendizado de máquina é tão boa quanto seus dados de treinamento. Se o processo de rotulagem é de má qualidade, então não há como garantir a qualidade dos resultados. O próprio efeito do stress das pessoas que rotulam esses dados precisa ser considerado.”

Fabiano também alertou para questões éticas.

“O projeto que originou a base de dados não tem nenhuma menção à aprovação por um Comitê de Ética em pesquisa. Pode haver diversos problemas com esses dados, inclusive com relação às leis de proteção de dados vigentes, como a LGPD. Também pode haver problemas de bias (viés) nos dados. Há diversos exemplos de algoritmos treinados com dados que resultam em modelos enviesados, que reproduzem preconceitos contra mulheres, pessoas negras, população lgbtqia+, indígenas, pessoas de classes socioeconômicas desfavorecidas, por exemplo. Sem falar na possibilidade do uso de labeling farms abusivas, o que levaria toda essa questão a um nível ainda mais desumano.”

Perguntamos ao Professor Fabiano se havia alguma possibilidade da IA utilizada no iWear ser a culpada pela falha do dispositivo. “Eu não diria ‘culpada’. Mas com dados muito homogêneos, obtidos de um projeto que não recebeu o aval de um comitê de ética, rotulados em um processo cuja qualidade não pode ser assegurada, e que pode envolver inclusive abusos de serviços terceirizados, não deverá ser surpresa se o algoritmo reproduzir resultados enviesados que afetem o funcionamento do dispositivo. O que surpreende mesmo é que a empresa estava ciente desses pontos, mas optou em prosseguir com o projeto do mesmo modo.”

A reportagem procurou Hélio Musk para comentar as últimas informações. Ele retornou defendendo que os dados utilizados pela Vina Systems foram obtidos dentro das normas éticas e legais, e de acordo com as práticas do mercado. Em nota, Musk criticou a polemização causada pela academia em cima do caso.

“Todos os projetos da Vina Systems são desenvolvidos de acordo com as legislações brasileira e internacional. A Vina Systems adota um processo rigoroso de qualidade em todas as suas ações, e tem consciência das responsabilidades envolvidas ao projetar sistemas de Inteligência Artificial. Nos causa surpresa que a universidade pública, que deveria focar em formar mão de obra qualificada para a sociedade, esteja se aproveitando do caso para polemizar. Falar em ‘comitê de ética’ e em ‘terceirização da mão de obra’ reflete um viés ideológico que claramente devemos afastar das universidades. A Vina Systems gera empregos a muitos dos alunos formados pela universidade, tendo periodicamente lançado editais para o pagamento de bolsas a alunos e professores. Porém, vamos rever nossas políticas de apoio e investir em instituições que formem a mão de obra especializada que a Vina Systems precisa.”

Para a chefia do Departamento de Informática, a nota reflete a falta de entendimento de seu autor sobre o papel e responsabilidade das universidades públicas, inclusive com o que está disposto na Constituição Federal e na Carta Magna Universitária. Procurado pela reportagem, o Prof. Luis Carlos E. de Bona comentou as declarações de Musk:

“É impossível negar que as descobertas científicas proporcionaram níveis de vida e benefícios que seriam inimagináveis para nossos antepassados. Sobrevivemos às pandemias, aumentamos nossa expectativa de vida, produzimos alimentos suficientes para sustentar uma população de bilhões de habitantes e criamos métodos de processamento de informação que expandiram nossa capacidade de colaborar e produzir conhecimento. Infelizmente, contradições de nossa sociedade impediram que esses benefícios fossem equitativamente, ou pelo menos justamente, distribuídos e acabaram por colocar em xeque o papel da ciência. Essa é uma crítica que nós cientistas temos que aceitar.

Porém a Universidade não pode ser acusada de criar polêmica ao aplicar seu conhecimento de forma crítica e ajudar a esclarecer um incidente de tamanha repercussão que colocou em cheque uma indústria bilionária. O papel social de uma Universidade Pública vai muito além da formação de mão de obra especializada, e o objetivo não é apenas atender as necessidades do departamento de recrutamento de talentos da Vina Systems. Buscamos formar pessoas altamente especializadas e que entendam os desafios tecnológicos que estão por vir e suas implicações éticas e sociais. Imparcialidade não é omissão, a sociedade pode ter certeza que a UFPR continuará se manifestando sobre assuntos de nossa especialidade de maneira rigorosa.”

Esse não é o primeiro caso em que o Departamento de Informática da UFPR tem atuado. Conhecido pela sua tradição em software livre, o departamento tem contribuído com projetos abertos que beneficiem toda a comunidade. Nos laboratórios de pesquisa do departamento, software livre é prioridade em detrimento de software proprietário. Nas últimas décadas, o departamento enfrentou diferentes perseguições por defender e fomentar a ciência aberta, lutar contra o aprisionamento de tecnologia, e promover o desenvolvimento de tecnologias livres.

A SBC Horizontes continua acompanhando o caso, e em breve trará mais informações.

Jade Scobri, Jornalista Científica

Jade Scobri, Jornalista Científica

Especialista em Tecnologias Computacionais

O Caso do Vestível Controlador © 2022 by Roberto Pereira, Fabiano Silva and Leticia Mara Peres is licensed under CC BY-NC-SA 4.0.